Книга: Учебное пособие по курсу «Нейроинформатика»

Предобработка, облегчающая обучение

Предобработка, облегчающая обучение

При обучении нейронных сетей иногда возникают ситуации, когда дальнейшее обучение нейронной сети невозможно. В этом случае необходимо проанализировать причины. Возможно несколько видов анализа. Одной из возможных причин является высокая сложность задачи, определяемая как выборочная оценка константы Липшица.

Для упрощения задачи необходимо уменьшить выборочную оценку константы Липшица. Наиболее простой способ добиться этого — увеличить расстояние между входными сигналами. Рассмотрим пару примеров — xi, xj — таких, что

Определим среди координат векторов xi и xj координату, в которой достигает минимума величина |xil-xjl|, исключив из рассмотрения совпадающие координаты. Очевидно, что эта координата является «узким местом», определяющим сложность задачи. Следовательно, для уменьшения сложности задачи требуется увеличить расстояние между векторами xi и xj, а наиболее перспективной координатой для этого является l-я. Однако увеличение расстояние между xil и xjl не всегда осмыслено. Дело в том, что все параметры, как правило, измеряются с конечной точностью. Поэтому, если величина |xil-xjl| меньше чем точность измерения l-го параметра, значения xil и xjl можно считать совпадающими. Таким образом, для изменения масштаба надо выбирать тот из входных параметров, для которого значение |xil-xjl| минимально, но превышает точность измерения этого параметра.

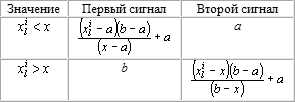

Таблица 7. Кодирование параметра после разбиения на два сигнала

Предположим, что все входные параметры предобработаны в соответствии с формулой (1). Перенумеруем примеры обучающего множества так, чтобы были верны следующие неравенства: xl1<xl2<,…,xlN, где N — число примеров в обучающем множестве. При этом, возможно, придется исключить ряд пар параметр-ответ с совпадающими значениями параметра. Если в какой-либо из таких пар значения ответов различаются, то это снижает возможную полезность данной процедуры.

Наиболее простой путь — разбить диапазон l-го параметра на два. Зададимся точкой x. Будем кодировать l-й параметр двумя входными сигналами в соответствии с табл. 7. При таком кодировании критерий Липшица, очевидно, уменьшится. Вопрос о выборе точки x может решаться по-разному. Простейший путь — положить x=(a-b)/2. Более сложный, но часто более эффективный — подбор x исходя из требования минимальности критерия Липшица.

Приведенный выше способ уменьшения критерия Липшица не единственный. В следующем разделе рассмотрен ряд способов предобработки, решающих ту же задачу.

- Нейрон

- Различимость входных данных

- Классификация компонентов входных данных

- Кодирование бинарных признаков

- Кодирование неупорядоченных качественных признаков

- Кодирование упорядоченных качественных признаков

- Числовые признаки

- Простейшая предобработка числовых признаков

- Оценка способности сети решить задачу

- Предобработка, облегчающая обучение

- Другие способы предобработки числовых признаков

- Составной предобработчик

- Позиционная предобработка

- Обучение работе с пакетом clab на демонстрационной задаче

- Функциональная предобработка

- Обучение команды

- Непрерывное обучение

- Глава 15. Эмпирическое обучение через исследование

- Глава 8. Обучение менеджеров по продажам

- Глава третья Обучение, память и парадигмы

- Что такое обучение

- Обучение конечных пользователей

- Профессиональные навыки и обучение независимых директоров

- ОБУЧЕНИЕ МОЗГА БЕЗ ВЫСОКИХ ТЕХНОЛОГИЙ