Книга: Продвижение порталов и интернет-магазинов

Спам и уязвимости

Спам и уязвимости

Поиск генерируемого контента. Контент, сгенерированный автоматически, с высокой долей вероятности будет расценен поисковой системой как спамный. Необходимо изучить сайт на предмет такого контента. Это делается ручным поиском блоков с генерированным контентом по матрице.

Проверка генерируемого контента на спамность. Если при генерации контента соблюдать определенные правила, он не будет расценен как спам. Необходимо изучить технологию генерации контента:

? изучить содержание блоков с генерируемым контентом;

? изучить генерируемый контент на предмет решения проблем пользователей;

? запросить у клиента и изучить ТЗ, по которому реализованы модули генерации.

Анализ исходящей рекламы на нарушение правил ПС. Согласно лицензии поисковой системы «Яндекс», сайт, использующий рекламу, мешающую пользователю находить нужную ему информацию, будет понижен в ранжировании. К таким видам рекламы относятся:

? попапы;

? тизеры;

? рич-медиа;

? редиректы;

? кликандеры;

? любые всплывающие окна.

Анализ SEOin/SEOout. При простановке ссылок важно учитывать значения SEOin/SEOout, чтобы избежать фильтрации на вес входящей ссылки:

? количество SEOin должно быть больше количества SEOout (сервисы RDS bar, Solomono);

? количество исходящих ссылок должно быть меньше количества страниц в индексе (сервисы RDS bar, Solomono, плагин Wink).

Проверка ошибок и спамности HTML-заголовков. Title и H1, Н2…Н6 могут быть заспамлены как намеренно, так и случайно. Необходимо изучить содержание Title и H1 – Н6 по всему сайту. Выявляются следующие проблемы:

? слишком длинные заголовки (бонус получают не все слова);

? дублирование Title, дублирование H1;

? множественный повтор ключевых слов («окна, окна, окна»);

? использование заголовков не по назначению (ссылки в меню, выделение жирным);

? несколько заголовков H1;

? отсутствие заголовков;

? отсутствие ключевых слов в заголовках;

? отсутствие связи между текстом и заголовками;

? совпадение Title и H1.

Проверка страниц на наличие скрытого текста. На странице может быть спамный или важный контент в невидимой области, скрытый при помощи CSS и JavaScript. К примеру, при наличии скрытых спамных ссылок сайт может быть пессимизирован. Способы решения проблемы:

? HTML-анализ страницы и поиск блоков скрытого текста;

? визуальный анализ страницы и выделение всего текста с помощью сочетания клавиш Ctrl+A;

? анализ с помощью плагина WebDeveloper для Firefox;

? поиск скрытых ссылок. Способы решения проблемы: со страницы (плагин Wink);

? поиск всех внешних ссылок с сайта (сервис «СайтРепорт»).

Проверка работы службы модерации контента. В результате действий модератора, систематически допускающего на сайт спамные объявления, сайт может быть пессимизирован. В моей практике был такой случай. Способы решения проблемы:

? поиск в индексе по спамным словам («порно», «диплом», «скачать», «бесплатно», «виагра», adult, viagra, free, blowjob, sex, movies);

? проверка с помощью ручного добавления спамного контента;

? установка плагина, автоматически определяющего спамные комментарии (сервис http://api.yandex.ru/cleanweb/).

Проверка работы контент-менеджеров. Неподготовленный контент-менеджер может допустить серьезную ошибку. Важно изучить работу контент-менеджера и подготовить для него инструкции. Проверять нужно:

? не копирует ли контент-менеджер из Word в визуальный редактор;

? публикует ли контент-менеджер через <HTML> или через визуальный редактор;

? выдерживает ли контент-менеджер стандарты оформления текста;

? крос-браузерны ли опубликованные страницы;

? не создаются ли дубли контента;

? нет ли на сайте индексируемых черновиков контента;

? проверяет ли контент-менеджер поставленные ссылки;

? учитывает ли контент-менеджер нужды SEO.

Поиск SEO-разделов, SEO-страниц и архивной версии сайта.

На старых сайтах иногда можно встретить пережитки прошлого: скрытый от пользователей раздел для SEO, архивную (старую) версию сайта, на которую нет ссылок. Важно убедиться в том, что эти страницы запрещены для индексации:

? изучить по HTML-карте сайта, какие существуют категории, сколько там страниц, какие у них URL;

? изучить список входных страниц;

? сравнить список страниц в индексе со списком страниц, найденных краулером (A-Parser или Xenu).

Проверка сайта на XSS-уязвимости. Если сайт имеет уязвимости, он может быть заражен вирусом, также может произойти утечка персональных данных пользователей, его могут использовать для простановки спамных ссылок. Виды проверок:

? с помощью сервиса Acunetix Web Vulnerability Scanner;

? по чек-листу (https://www.owasp.org/index.php/XSS_Filter_Evasion_Cheat_Sheet).

Проверка текстов на наличие грамматических ошибок и опечаток. Орфографические и грамматические ошибки снижают доверие пользователей к сайту. Проверка орфографии выполняется с помощью сервиса http://www.webmaster.yandex.ru/spellcheck.xml.

Анализ сайта на клоакинг. Некоторые веб-мастера все еще используют клоакинг с целью манипуляции поисковой системой. Необходимо проверить сайт:

? сравнить кэш страницы с текущей версией;

? сравнить содержание страницы с копией в «СайтРепорт» (по умолчанию представляется user-agent: «Яндек.Бот»);

? выполнять поиск клоакинга в продаваемых ссылках;

? выполнять поиск клоакинга в контенте.

Изучение списка исходящих внешних ссылок. Важно убедиться в том, что на сайте нет несанкционированных ссылок и ссылок на спамные сайты, в частности, что сайт не продает ссылки через биржи:

? получить список ссылок на внешние сайты с помощью сервисов Solomono, «СайтРепорт»;

? искать спамные сайты и несанкционированные ссылки.

Проверка IP-адреса хостинга на наличие спамных сайтов. По IP-адресу могут располагаться спамные и забаненные сайты. Об их наличии и содержании лучше узнать сразу – проверить через запрос ip:255.255.255.255 в Yahoo!, где 255.255.255.255 – адрес сервера.

Проверка сайта на фильтры в «Яндексе» и Google. Сайт может находиться под санкциями. Различают довольно большое количество фильтров, которые условно можно объединить в три группы: фильтр на домен, фильтр на страницу, фильтр на ссылку. Признаками санкций являются:

? ухудшение позиций сайта в поисковой выдаче (выявляется изучением динамики изменений позиций сайта за длительный период);

? выпадение страниц из индекса (обнаруживается в результате изучения динамики индексации сайта);

? обнуление или уменьшение значений тулбарных метрик (выявляется изучением ТИЦ и PR);

? падение трафика (обнаружить поможет изучение данных «Яндекс.Метрики», Google.Analytics);

? информеры ПС (проверяется изучением данных «Яндекс.Вебмастера», GoogleWebmaster);

? исключение сайта из каталога «Яндекса» или отказ в добавлении в каталог (это покажет проверка в скрытой части «Яндекс.Каталога» через запрос http://bar-navig.yandex.ru/u?ver=2&url=http://site.ru&show=1).

Проверка страниц на фильтры в «Яндексе» и Google. SEO-специалист, который ранее продвигал сайт, мог перестараться с оптимизацией продвигаемых страниц. Проверяется:

? падение позиций запроса или группы запросов (изучением динамики изменений позиций по запросам и группам запросов за длительный период);

? наличие страницы в индексе.

Проверка ссылочной массы на фильтры в «Яндексе» и Google. Ошибки SEO-специалиста могут привести к тому, что закупка части ссылок приносит убытки:

? наблюдается обнуление ТИЦ;

? по купленным проиндексированным ссылкам позиции не растут;

? позиции по запросам падают или стагнируют.

Проверка ссылочной массы на спамность доноров. Проверить, рабочая ли конкретная ссылка, невозможно, но можно исключить подозрительные сайты из ссылочной массы. Факторы для изучения:

? трафик;

? SEOin или SEOout;

? отношение числа ссылок к числу страниц в индексе.

Поведенческие накрутки. Важно узнать, не предпринимаются ли осознанные или неосознанные действия по накрутке поведенческих факторов. Об этом свидетельствуют:

? необоснованный рост трафика по некоторым запросам, опережающий рост позиций (или вообще при отсутствии роста позиций) (сервисы «Яндекс.Метрика», Google Analytics);

? рост трафика при отсутствии роста конверсии (сервисы «Яндекс.Метрика», Google Analytics).

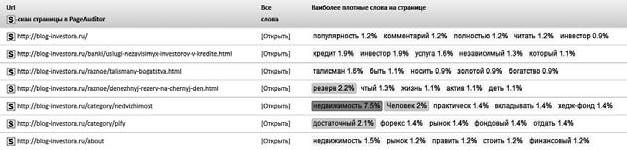

Проверка текстов на спамность ключевых слов. Страницы с заспамленными текстами могут быть пессимизированы. Чтобы не допустить этого, нужно использовать любой сервис, который строит график распределения ключевых слов (функция page auditor и лексикологический анализ в «СайтРепорт») (рис. 10.8).

Проверка IP на наличие в базах спама. IP-адрес, по которому расположен сервер заказчика, с которого уходят уведомления о регистрациях и рассылка для пользователей, может содержаться в спам-листах. Проверить это можно с помощью сервиса http://2ip.ru/spam/.

Рис. 10.8

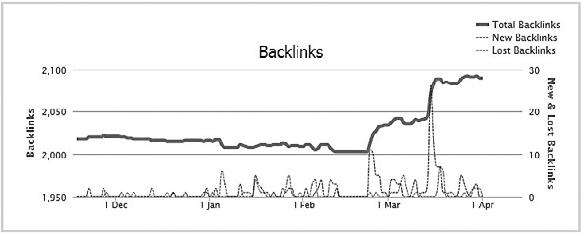

Проверка на ссылочные взрывы. Неквалифицированный SEO-специалист может закупить непропорционально большое количество ссылок за короткий период, вызвав эффект ссылочного взрыва. В этом случае купленные в определенный период ссылки перестают учитываться и бюджет расходуется впустую (рис. 10.9). Проверка выполняется с помощью сервисов http://MajesticSEO.com и http://Ahrefs.com.

Рис. 10.9

- Общий анализ сайта

- Матрица сайта

- Изучение тематики

- Хостовые факторы

- Индексация

- Дублирование, аффилиаты, ошибки

- Региональность

- Спам и уязвимости

- Факторы авторитетности

- URL-факторы

- Семантическое ядро

- Юзабилити

- Сниппеты

- Внутренние ссылки

- Статический вес

- Анкоры

- Естественные ссылки

- Текстовые факторы (важные зоны документа)

- Анализ эффективности продвижения

- Бизнес-аналитика

- Сводная таблица

- 8.6. Спам

- 8.6.1. Блокировка приема спама

- 8.6.2. Блокировка пересылки спама

- 1.1.3. Уязвимости процессов накопления знаний (самообучения)

- 23.2. Защита от спама

- Настройка сервера для борьбы со спамом

- Конфигурация sendmail для противодействия попыткам передачи спама

- Настройка Exim для противодействия распространению спама

- Настройка Postfix для противодействия распространению спама

- Обман поисковых систем. Спамдексинг. Клоакинг. Дорвеи. Свопинг

- Глава 2. Спам, вирусы, компьютерный шпионаж

- 4.1. Что такое спам?