Книга: Как сделать свой сайт и заработать на нем. Практическое пособие для начинающих по заработку в Интернете

5.1. Что такое SEO и с чем ее едят? Как работают поисковые системы?

5.1. Что такое SEO и с чем ее едят? Как работают поисковые системы?

Аббревиатура SEO означает Search Engine Optimization, что можно перевести на русский язык как «оптимизация для поисковых машин». «Википедия» дает следующее уточнение.

SEO – комплекс мер для поднятия позиций сайта в результатах выдачи поисковых систем по определенным запросам пользователей. Обычно чем выше позиция сайта в результатах поиска, тем больше заинтересованных посетителей переходит на него с поисковых систем. При анализе эффективности поисковой оптимизации оценивается стоимость целевого посетителя с учетом времени вывода сайта на указанные позиции и конверсии сайта, на который привлекаются целевые посетители.

Начинающим веб-мастерам надо понять лишь то, что для высокого заработка необходимо обеспечить высокую посещаемость сайта (высокий трафик), то есть «раскрутить» сайт.

Пользователи могут попасть на сайт двумя способами:

• ввести адрес страницы сайта (URL) в адресную строку браузера;

• перейти по ссылке.

В зависимости от способа источники трафика делятся на три основные группы, подразумевающие:

• переход на сайт за счет указания URL;

• переход со ссылающихся сайтов;

• использование поисковых систем (поисковых машин, поисковых серверов, поисковиков).

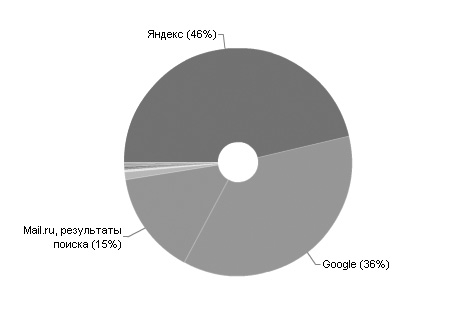

Поисковый трафик самый ценный, так как большинство людей при поиске информации используют поисковые системы. Самые популярные в России поисковики – «Яндекс» и Google. Для подтверждения этих слов предлагаем вам данные одного нашего сайта, неоптимизированного ни под одну поисковую систему (рис. 5.1).

Рис. 5.1. В России наиболее популярны поисковики «Яндекс» и Google

Как мы ищем информацию в Интернете? Мы запрашиваем ее у поисковой машины, то есть делаем запрос.

Запрос – это слово либо словосочетание, которое пользователь вводит в поисковую строку поисковой машины. Иными словами, запрос – это ключевое словосочетание, по мнению пользователя максимально отвечающее сути той информации, которую он хочет найти.

Главная задача поисковых сервисов – это приближение оценок поисковой машины к человеческой оценке. Иначе говоря, надо сделать так, чтобы автомат принимал решение, как человек. Поисковики заявляют, что для них хороши те же сайты, что и для пользователя – с прозрачной структурой, правильно оформленными текстами. Они утверждают, что специальная оптимизация не требуется – нужно просто делать хорошие сайты, сайты для людей (СДЛ).

Надо заметить, что из года в год алгоритмы работы поисковых систем становятся все совершенней. Как нам кажется, повторяется история с компьютерными программами, играющими в шахматы. Лет двадцать назад многие любители шахмат утверждали, что компьютер никогда не сможет играть с человеком в шахматы на равных, а тем более уверенно его обыгрывать. События последних лет показывают, что скоро компьютер не оставит человеку ни малейшего шанса на выигрыш.

Наверняка со временем поисковые системы научатся не хуже человека определять качество контента, и это надо учитывать, работая над сайтами. У каждой поисковой системы есть свои роботы-программы, которые бродят по Интернету и записывают в базу данных все замеченные изменения. Как и обычные пользователи, роботы перемещаются по ссылкам, которые находят на веб-страницах. Но если на сайт или веб-страницу нет ссылок, то они окажутся незамеченными роботами.

У поисковиков несколько видов роботов, каждый из которых занимается своей работой. Например, есть робот, который индексирует RSS-ленту для поиска по блогам, а есть робот, который занимается только индексированием картинок. Но самым важным является индексирующий робот, который заносит информацию о найденных сайтах в базу данных основного поиска. Если сайт не занесен в эту базу, то на него не получится перейти с поисковой системы, так как она о нем не будет знать.

Увы, быть занесенным в базу данных – это ничто по сравнению с необходимостью попадания в так называемый ТОП, то есть верх списка.

• ТОП10 – это 10 первых результатов выдачи поисковика, которые находятся на первой странице;

• ТОП20 – как вы понимаете, список начинается на второй странице, на которую заходят только порядка 13 % пользователей;

• ТОП30 – на третьей странице заканчивается так называемая «зона видимости сайта», так как дальше третьей страницы добирается лишь мизерная доля пользователей.

Задача любого веб-мастера – стремиться к тому, чтобы по интересующим ключевым фразам сайт оказался на первой странице, то есть попал в ТОП10.

Что может быть круче, чем ТОП10? Это ТОП5 либо ТОП3 – идеальное местонахождение для сайта.

Отвечая на запрос пользователя, поисковая машина ранжирует (располагает в определенном порядке) сайты в зависимости от релевантности.

Релевантность – это соответствие найденного материала запросу пользователя. Иными словами, поисковая машина должна понять, что именно хочет найти пользователь, и выдать ссылки на материал, который наиболее точно отвечает запросу.

На данный момент в Интернете можно найти большое количество информации на тему, как надо писать статью, чтобы она оказалась в ТОПе. Приведем несколько рекомендаций:

• заголовок должен быть читаемым и не длинным;

• если текст большой – обязательно разделяйте его заголовками h1-h6;

• вхождение запроса на странице должно хотя бы один раз выделяться одним из тегов;

• текст должен быть естественным, без явного «переспама»;

• на продвигаемой странице должны присутствовать картинки, желательно уникальные; картинки – дополнительная информативность и полнота содержания и т. д.

Вроде все написано правильно, и возникает впечатление, что автору статьи удалось разгадать алгоритм ранжирования, используемого поисковыми машинами. Но почему посещаемость сайта, на котором размещена эта замечательная статья, не дотягивает даже до 500 посетителей в сутки?

Увы, ответ очень прост: автор немного лукавит, утверждая, что все так просто, как он преподносит. На самом деле все намного сложнее. Иногда возникает впечатление, что поисковики норовят каждую секунду вносить изменения в алгоритмы работы. Чтобы более наглядно проиллюстрировать работу поисковика «Яндекс», мы попросили нашего художника нарисовать такую иллюстрацию (рис. 5.2).

Рис. 5.2. Разгадать алгоритм работы «Яндекса» «очень просто» – нужно угадать, в какое положение обезьяна поставила определенное количество ползунков

В принципе, можно прикинуть, какие ползунки могут быть на микшерском пульте. Например, это:

• количество заголовков h2 (h3-h6);

• количество слов, выделенных полужирным шрифтом;

• наличие и количество слов из «титула» (контейнера <title></title>) в первом абзаце и т. д.

Теперь остается только угадать, в какое положение обезьяна поставила определенное количество ползунков. Как вы понимаете, сделать это невозможно. Кроме того, «Яндексу» присущи некоторые «чудеса», связанные с изменением алгоритмов работы.

Приведем пример из нашей скромной практики. Один из наших сайтов держался по интересующему нас запросу в ТОП5 «Яндекса» на протяжении довольно длительного времени: около года. В один прекрасный день по этому запросу сайт вдруг оказался на 89-м месте. Что случилось? Да ничего особенного, просто изменился алгоритм работы «Яндекса». Такие ситуации возникают весьма часто и иногда даже радуют, если происходит взлет, но, увы, бывают и серьезные падения.

Совет

Если вы начинающий веб-мастер, не тратьте свое время на разгадывание алгоритмов работы поисковых систем. Каждый раз, когда у вас появится такое желание, вспоминайте об обезьяне за микшерским пультом.

- 5.1. Что такое SEO и с чем ее едят? Как работают поисковые системы?

- 5.2. Целевые посетители и семантическое ядро

- 5.3. Тайна за семью печатями, или Информация, расположенная под носом?

- 5.4. Разновидности запросов

- 5.5. Комментарии, или «Манна небесная»

- 5.6. Сборник рецептов «Написание статей с оглядкой на „Яндекс"»

- 5.7. Блок «Поделиться» – способствуем распространению своего контента

- 5.8. Что такое тИЦ и PR? Насколько они важны для продвижения?

- 5.9. Где следует расставлять ссылки?

- 5.10. Продвижение за счет покупки ссылок. Небольшой эксперимент с SeoPult

- 5.11. Дополнительная литература по SEO

- 5.12. Выводы

- 1.1.1. Что такое объект

- Особенности системы защиты данных в InterBase

- Что делать

- Что делать, если при установке принтера появляется сообщение Невозможно завершение операции. Подсистема печати недоступн...

- Что дает грамотная должностная инструкция

- Как сделать, чтобы компьютер выключался

- ПОМОГАЙТЕ ДРУГИМ ПРИДЕРЖИВАТЬСЯ ПОЧТОВОГО «ЭТИКЕТА»

- Предисловие Кое-что новенькое – поговорим напрямую

- На что обращать внимание

- Что такое продажа?

- Установка системы на уже подготовленный жесткий диск

- 1.3. Системы счисления