Как сегодня правильно закрыть сайт от индексации, чтобы это устроило и Яндекс и Гугл? |

||||

|---|---|---|---|---|

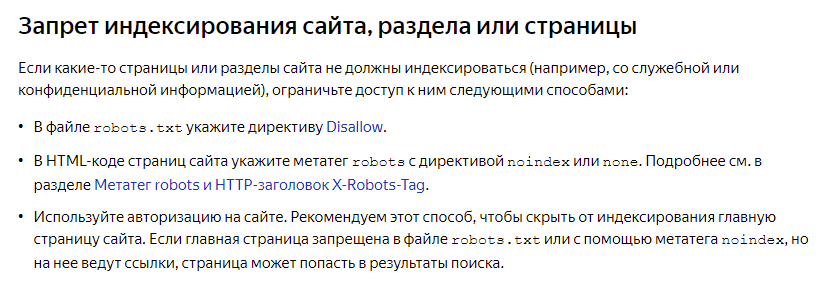

О том, для чего вообще закрывают сайты от индексации в поисковых системах вы можете прочитать ниже, а сейчас давайте перейдём сразу к конкретике! На момент публикации поста в своих мануалах Яндекс советует вот что:

Ссылка на мануал https://yandex.ru/support/webmaster/adding-site/indexing-prohibition.html А вот что советует Гугл:

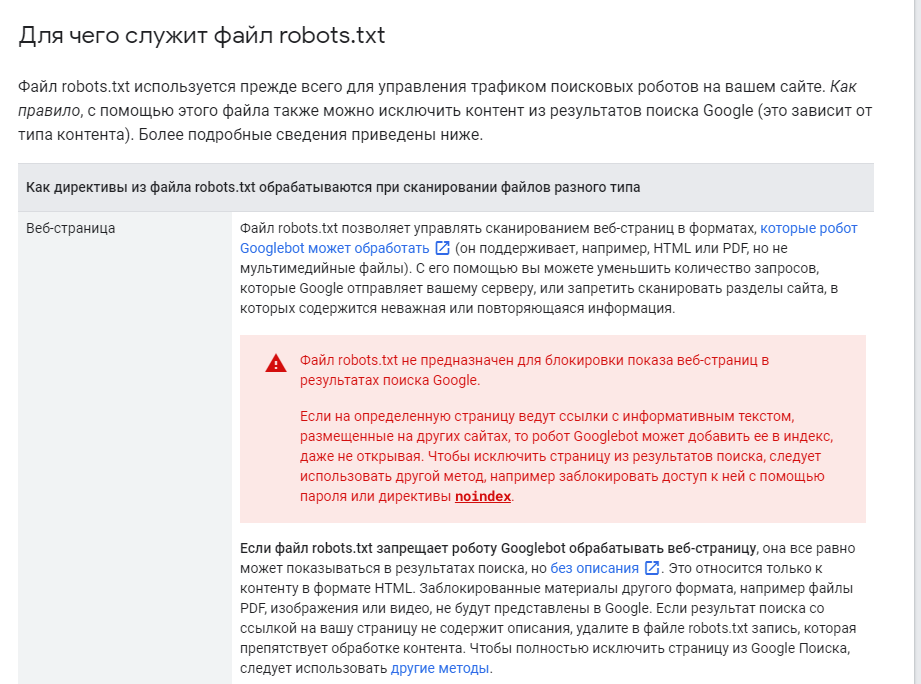

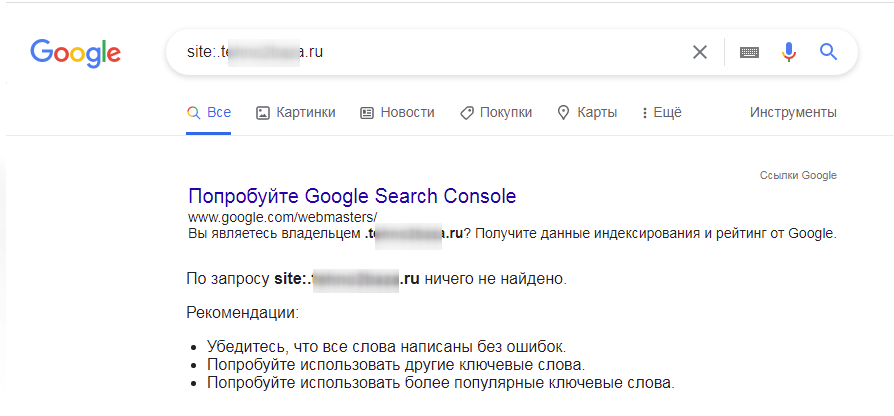

Ссылка на мануал https://developers.google.com/search/docs/advanced/crawling/block-indexing?hl=ru Как видим советы несколько разнятся. До недавнего времени эффективно работала связка: Disallow: / в robots.txt и , но с последними нововведениями Гугла так лучше больше не делать поскольку robots.txt не предназначен для блокировки показа веб-страниц в результатах поиска Google. Поэтому… Для сайтов, что уже в индексе: на сегодня наиболее эффективный и не конфликтный способов это на всех страницах. Так же вам нужно не забыть удалить или закомментировать все счетчики посещаемости. И через время сайт в поиске вы уже не найдете, ни в Яндекс, ни в Гугл.

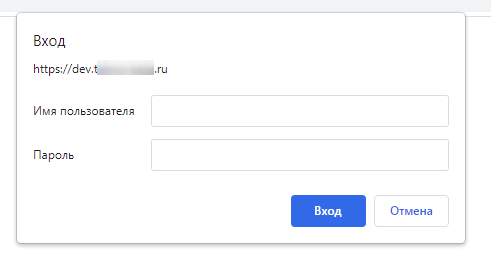

Для новых сайтов, чтобы не попали в индекс делайте в robots.txt вот такое содержимое: User-agent: * Но опять же, если главная страница запрещена в файле robots.txt или с помощью метатега noindex, но на нее ведут ссылки, страница может попасть в результаты поиска. Поэтому единственный железобетонный метод это закрыть сайт на уровне хостинга, т.е. поставить на папку логин/пароль, чтобы при заходе на него вылетало вот такое окно:

Для чего вообще закрывают сайты от индексации в поисковых системах?

Если вам не хватает навыков, чтобы воспользоваться инструкциями выше и закрыть свой сайт от поиска, вы можете обратиться к нашим хорошим друзьям, компании 39 сайтов и они вам помогут в этом вопросе. Необходимо будет предоставить доступ по FTP или в панель вашего хостинга. Стоимость услуги «Закрыть сайт от поисковиков» на момент публикации поста всего 1000 рублей. |

||||

- Тупит, висит, не грузит сайт? Забудь эти слова со студией WRP, которая устроит переезд на Битрикс (Ранг: 3 )

- Как правильно регистрировать сайт (Ранг: 3 )

- Как найти разработчика сайтов на Битрикс в Москве (Ранг: 2 )

- Как правильно выбрать сервер для бизнеса (Ранг: 2 )

- Проверка позиций сайта в поисковой системе Яндекс (Ранг: 2 )

- Как выбрать правильные ключевые слова для сайта: стратегии и инструменты (Ранг: 2 )

- Как эффективно и быстро раскрутить сайт (Ранг: 2 )